Bạn có bao giờ thắc mắc crawl là gì và tại sao nó lại quan trọng trong hoạt động SEO không? Đây là một khái niệm then chốt giúp công cụ tìm kiếm như Google khám phá, lập chỉ mục nội dung trên website của bạn và mở ra cánh cửa tiếp cận nhiều khách hàng tiềm năng hơn.

Đọc ngay bài viết dưới đây để cùng Pima Digital tìm hiểu từ A đến Z nguyên lý hoạt động cũng như những cách giúp website được crawl dữ liệu dễ dàng nhé!

Crawl là gì? 6 cách giúp Crawl data website dễ dàng, tối ưu

Crawl là gì? Crawl data là gì?

Đây là thuật ngữ dùng để chỉ quá trình mà các công cụ tìm kiếm như Google thực hiện quét và thu thập dữ liệu từ các nguồn trên Internet. Các loại dữ liệu được thu thập có thể bao gồm trang web, hình ảnh, video, tài liệu PDF, hoặc bất kỳ định dạng nội dung nào khác.

Quá trình này được thực hiện bởi các chương trình tự động gọi là “bot”, “crawler” hoặc “spider”. Những bot này di chuyển qua các liên kết trên website, khám phá từng trang và ghi nhận thông tin.

Sau khi quá trình crawl hoàn tất, dữ liệu được chuyển đến giai đoạn lập chỉ mục (Google index). Đây là bước mà search engine sắp xếp và lưu trữ thông tin, sẵn sàng hiển thị các kết quả phù hợp khi người dùng nhập từ khóa tìm kiếm. Crawl không chỉ giúp nội dung trên website của bạn được bots tìm thấy mà còn đóng vai trò quan trọng trong việc xác định thứ hạng trên trang kết quả tìm kiếm.

Crawl data là gì?

Tại sao crawl data lại quan trọng cho website?

Crawl website đóng vai trò nền tảng trong việc giúp các công cụ tìm kiếm khám phá và hiểu nội dung trên trang web của bạn. Nếu quá trình này không được thực hiện, thông tin trên website sẽ không thể xuất hiện trong kết quả tìm kiếm, khiến bạn bỏ lỡ cơ hội tiếp cận người dùng.

Đây không phải là một hoạt động diễn ra duy nhất một lần mà là một quá trình liên tục. Các bot thường xuyên quét lại website để cập nhật dữ liệu, bổ sung nội dung mới và đảm bảo chỉ mục luôn phản ánh chính xác thông tin trên trang.

Ví dụ, nếu các bài viết về tin nóng, sự kiện đã qua, hoặc sản phẩm đã hết hàng không được crawl và hiển thị nhanh chóng, chúng sẽ trở nên vô nghĩa với người dùng. Thông tin cần phải được cập nhật kịp thời để duy trì giá trị.

Vai trò của crawl data là gì đối với website?

Cách thức hoạt động của Crawl là gì?

Khám phá các URL website

Các search engine bắt đầu bằng việc tìm kiếm các URL trên trang web thông qua sơ đồ trang web (sitemap), liên kết nội bộ (internal link) và liên kết từ các trang web khác. Ví dụ, khi bạn tạo một bài viết mới và liên kết đến từ trang chủ, các bot sẽ dễ dàng phát hiện bài viết này thông qua liên kết nội bộ.

Kiểm tra các file robot.txt

Trước khi quét nội dung, các bot kiểm tra tệp robots txt của trang web để xác định các phần nào được phép truy cập và các phần nào bị chặn. Điều này giúp đảm bảo rằng các bot chỉ truy cập vào những nội dung mà chủ sở hữu trang web muốn chúng cào.

Bot kiểm tra tệp robots.txt để xác định phần được phép và phần bị chặn trên website

Đánh giá và ưu tiên

Các bot đánh giá các trang web dựa trên các chỉ số như lưu lượng truy cập (traffic), số lượng backlinks và độ tin cậy của trang web. Dựa trên những dữ liệu này, chúng xác định thứ tự ưu tiên thu thập thông tin từ các trang web.

Thu thập dữ liệu

Sau khi xác định các trang được phép truy cập, các bot sẽ quét và thu thập dữ liệu từ các trang đó, bao gồm văn bản, hình ảnh, video và các liên kết khác. Dữ liệu này sau đó được lưu trữ và gửi đến hệ thống lập chỉ mục (index) của bộ máy tìm kiếm.

Cơ chế hoạt động của crawl dữ liệu là gì?

Cập nhật thông tin

Trong quá trình tìm hiểu crawl là gì và cách nó hoạt động, Pima Digital biết được quy trình crawl không dừng lại sau lần quét đầu tiên. Các bot sẽ liên tục kiểm tra lại các trang web đã thu thập trước đó để cập nhật những thay đổi hoặc thông tin mới. Điều này đảm bảo rằng cơ sở dữ liệu của công cụ tìm kiếm luôn phản ánh nội dung chính xác và mới nhất.

Ví dụ: Hãy tưởng tượng bạn có một thư viện sách. Các bot (spider) giống như những người thư ký, họ đi khắp thư viện để tìm và ghi chép thông tin về từng cuốn sách. Khi có một cuốn sách mới được thêm vào, họ sẽ phát hiện thông qua các liên kết từ các cuốn sách khác hoặc thông báo từ bạn và tiến hành cập nhật vào kho sách.

Quá trình crawl sẽ diễn ra liên tục và cập nhật thông tin mới nếu có

7 cách giúp công cụ tìm kiếm crawl data website dễ dàng

Sau khi đã hiểu rõ crawl là gì và cơ chế hoạt động của nó, hãy cùng Pima Digital khám phá những phương pháp hiệu quả giúp website của bạn dễ dàng được crawl dữ liệu và tối ưu hóa khả năng xuất hiện trên các kết quả tìm kiếm.

Kiểm tra tệp robots.txt

Tệp robots.txt trên website giúp bạn giao tiếp với các bot thông qua các chỉ thị. Tệp này nằm ở thư mục gốc của trang web và có thể truy cập qua đường dẫn yourdomain/robots.txt.

Để chỉnh sửa tệp robots.txt, bạn cần sử dụng ứng dụng FTP hoặc có quyền truy cập vào cPanel của máy chủ (hosting). Khi chỉnh sửa tệp này, hãy chắc chắn rằng không ngăn cản các bot có thể truy cập vào những trang web mà bạn muốn chúng lập chỉ mục. Nếu nắm vững các lệnh trong robots.txt, có thể dễ dàng kiểm tra lỗi như noindex hoặc nofollow.

Nếu bạn chưa quen thuộc với các lệnh này, có thể sử dụng công cụ kiểm tra robots.txt qua công cụ Google Search Console hoặc Rich Results Test tại đây để phát hiện vấn đề. Cuối cùng, nhớ kiểm tra để đảm bảo các bot có thể truy cập tệp robots.txt, nếu bị chặn ở cấp máy chủ, các bot sẽ không thể đọc và làm theo chỉ thị.

Những cách giúp website được crawl data dễ dàng

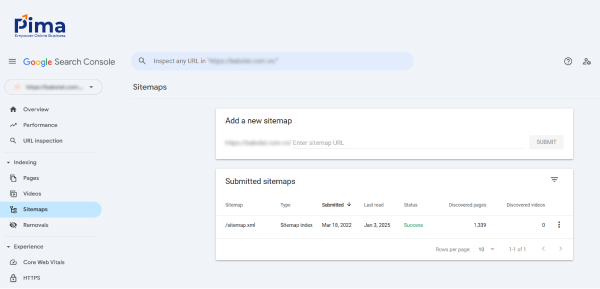

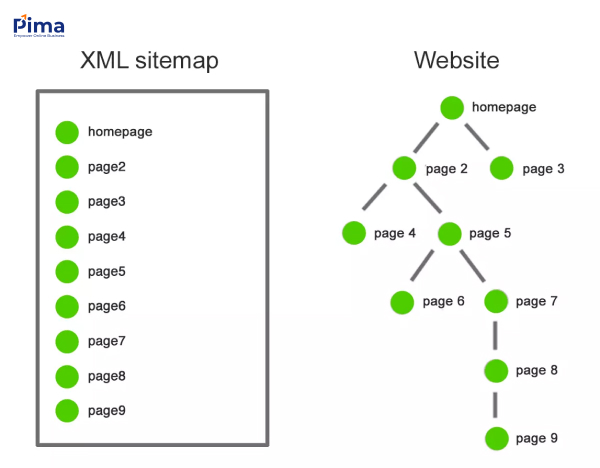

Tận dụng sitemap

Sơ đồ trang web là một tệp XML liệt kê tất cả các trang trên website mà bạn muốn công cụ tìm kiếm lập chỉ mục. Để gửi sơ đồ này, bạn có thể sử dụng Google Search Console: vào mục “Indexing”, chọn “Sitemaps” và nhập URL của sơ đồ. Quá trình này cũng tương tự với các công cụ tìm kiếm khác như Bing.

Nếu trang web của bạn sử dụng WordPress, các plugin SEO như Yoast hoặc Rank Math sẽ tự động tạo sơ đồ trang web cho bạn và cung cấp đường dẫn để gửi. Đường dẫn này thường có dạng: yourdomain/sitemap_index.html.

Sitemap liệt kê các trang trên website để công cụ tìm kiếm lập chỉ mục

Cải thiện tốc độ trang web

Cách có thể giúp Googlebot và các search engine khác quét nhiều URL hơn trên trang của bạn. Theo Google, làm cho website nhanh hơn không chỉ cải thiện trải nghiệm người dùng mà còn tăng tần suất crawl data.

Nói cách khác, các trang tải chậm làm mất thời gian quý giá của Googlebot và khó để được crawl. Ngược lại, nếu website của bạn tải nhanh, Googlebot có thể có đủ thời gian để ghé thăm và lập chỉ mục nhiều trang hơn.

Bạn có thể kiểm tra hiệu suất website nhanh chóng với công cụ Google PageSpeed Insights giúp tối ưu hóa tốc độ và trải nghiệm người dùng.

Cải thiện tốc độ tải trang cũng giúp website được thu thập dữ liệu dễ dàng

Tránh hiện tượng Orphan Pages (Trang mồ côi)

Đây là những trang không có bất kỳ internal link hay backlink nào trỏ tới chúng. Nếu một trang không có liên kết nào, Google sẽ gặp khó khăn trong việc tìm thấy và thu thập dữ liệu từ trang đó. Để tận dụng tối đa ngân sách crawl, hãy đảm bảo mỗi trang trên website của bạn đều có ít nhất một liên kết trỏ đến, dù là liên kết nội bộ hay liên kết ngoài.

Orphan Pages là những trang không có bất kỳ internal hay backlink nào

Đặt internal link giữa các trang trong website

Liên kết nội bộ là cầu nối quan trọng giúp Googlebot di chuyển qua các trang trên website của bạn một cách hiệu quả. Khi bạn đặt liên kết giữa các trang trong cùng một website, bạn không chỉ giúp người dùng dễ dàng điều hướng mà còn giúp các công cụ tìm kiếm tìm thấy và lập chỉ mục nội dung nhanh chóng.

Đảm bảo rằng mỗi trang quan trọng đều có ít nhất một liên kết nội bộ trỏ tới. Điều này giúp Googlebot tiếp cận và lập chỉ mục toàn bộ website mà không bỏ sót trang nào.

Đặt liên kết nội bộ liên kết với các bài viết khác có nội dung liên quan

Giảm thiểu lỗi 404 và redirect không cần thiết

Các lỗi 404 (trang không tìm thấy) hay các trang redirect (chuyển hướng) không hợp lý có thể gây khó khăn cho Googlebot khi quét và lập chỉ mục website của bạn. Hãy kiểm tra thường xuyên để đảm bảo không có trang nào bị lỗi 404.

Đồng thời, tránh sử dụng quá nhiều redirect nếu không thật sự cần thiết. Redirect không hợp lý không chỉ làm chậm quá trình quét mà còn có thể ảnh hưởng đến hiệu suất SEO của bạn. Đảm bảo rằng tất cả các trang đều có liên kết chính xác và hoạt động tốt.

Hạn chế các lỗi 404 và redirect để không ảnh hưởng trong quá trình crawl data

Sử dụng các tool để phát hiện lỗi về crawl và index

Để đảm bảo rằng website của bạn không gặp phải vấn đề về khả năng quét và lập chỉ mục, hãy sử dụng các công cụ chuyên dụng như Google Search Console, Ahrefs, hoặc Screaming Frog để kiểm tra và phát hiện lỗi.

Những công cụ này sẽ giúp bạn xác định các trang gặp vấn đề với crawlability (khả năng quét) và indexability (khả năng lập chỉ mục). Khi phát hiện vấn đề, bạn có thể nhanh chóng sửa chữa, giúp cải thiện hiệu quả SEO và khả năng hiển thị của website trên kết quả tìm kiếm.

Screaming Frog là tool phổ biến để crawl cho website

7 yếu tố ảnh hưởng đến việc crawl dữ liệu

Tên miền (Domain)

Domain của bạn đóng vai trò quan trọng trong việc xác định độ tin cậy và uy tín của trang web. Một tên miền tồn tại lâu dài và có lịch sử tốt sẽ được các công cụ tìm kiếm đánh giá cao hơn, từ đó tăng khả năng được thu thập và lập chỉ mục.

>> Tìm hiểu thêm: Domain là gì? Cách chọn tên miền tối ưu cho doanh nghiệp

Backlinks

Liên kết từ các trang web khác trỏ về trang của bạn (backlinks) giúp tăng độ tin cậy và khả năng được thu thập dữ liệu. Các bot tìm kiếm coi đây là tín hiệu cho thấy nội dung của bạn có giá trị, đáng tin cậy và dễ dàng được crawl dữ liệu.

Backlinks giúp tăng độ tin cậy và khả năng được thu thập dữ liệu

Liên kết nội bộ (Internal Links)

Cấu trúc liên kết nội bộ hợp lý giúp các bots dễ dàng di chuyển và thu thập dữ liệu trên trang web của bạn. Đảm bảo rằng mỗi trang quan trọng đều có ít nhất một liên kết nội bộ trỏ đến.

Sơ đồ trang web (Sitemap)

Sitemap cung cấp cho các công cụ tìm kiếm danh sách tất cả các trang quan trọng trên trang web của bạn. Việc gửi sơ đồ trang web giúp Google bots hiểu rõ cấu trúc website và thu thập dữ liệu hiệu quả hơn.

Sơ đồ trang web liệt kê các trang quan trọng trên website cho công cụ tìm kiếm

Nội dung trùng lặp (Duplicate Content)

Duplicate Content xảy ra khi cùng một nội dung xuất hiện trên nhiều trang web hoặc trên cùng một trang với các URL khác nhau. Điều này gây khó khăn cho các công cụ tìm kiếm khi xác định trang nào nên được lập chỉ mục. Hãy đảm bảo rằng nội dung trên trang web của bạn là duy nhất và có giá trị.

Sử dụng thẻ Canonical (Canonical URL)

Sử dụng thẻ canonical giúp chỉ định phiên bản chính thức của một trang, tránh việc nội dung trùng lặp và đảm bảo rằng các công cụ tìm kiếm thu thập dữ liệu đúng trang.

>> Tìm hiểu thêm: Thẻ Canonical là gì? 5 quy tắc tối ưu Canonical URL hiệu quả

Thẻ Meta (Meta Tags)

Meta Tags đặc biệt là thẻ “robots“, hướng dẫn các bots cách thu thập dữ liệu và lập chỉ mục trang web của bạn. Hãy chắc rằng các thẻ meta được cấu hình chính xác để hỗ trợ quá trình crawl data tốt hơn.

Thẻ meta “robots” nên được cấu hình chính xác để hỗ trợ quá trình crawl

6 công cụ Crawl data hiệu quả nhất hiện nay

- Google Bot: Công cụ thu thập dữ liệu chính của Google, giúp quét và lập chỉ mục các trang web, đảm bảo thông tin luôn được cập nhật nhanh chóng

- Bingbot: ương tự như Google Bot, Bingbot là công cụ thu thập dữ liệu của Bing. Nó giúp cải thiện khả năng hiển thị và thứ hạng của các trang web trên Bing thông qua việc thu thập và lập chỉ mục dữ liệu từ các trang web

- Scrapy: Đây là một framework mã nguồn mở, cho phép người dùng xây dựng các web crawlers tùy chỉnh để thu thập và xử lý dữ liệu từ các trang web. Scrapy được ứng dụng rộng rãi trong các dự án khai thác dữ liệu, phân tích thông tin và tự động hóa các tác vụ trên web

- Screaming Frog SEO Spider: Công cụ SEO này giúp phân tích các yếu tố quan trọng của trang web như liên kết, metadata và cấu trúc URL, hỗ trợ tối ưu hóa trang web

- Apache Nutch: Đây là tool crawling mã nguồn mở rất linh hoạt, Apache Nutch được sử dụng trong các dự án tìm kiếm tùy chỉnh và xử lý dữ liệu web quy mô lớn, cho phép người dùng điều chỉnh cấu hình để phù hợp với các nhu cầu đặc thù của dự án

- Heritrix: Đây cũng là mã nguồn mở được phát triển đặc biệt để phục vụ các dự án bảo tồn web và lưu trữ nội dung số.

Giao diện công cụ Apache Nutch

Câu hỏi thường gặp

Crawl và index có giống nhau không?

KHÔNG, crawl là quá trình Googlebot quét các trang web để thu thập dữ liệu, trong khi index là bước tiếp theo khi dữ liệu được lưu trữ và sử dụng để hiển thị trong kết quả tìm kiếm.

Quá trình crawl dữ liệu có làm tổn hại đến trang web không?

KHÔNG, tuy nhiên nếu trang web có quá nhiều yêu cầu từ Googlebot, có thể ảnh hưởng đến hiệu suất của server.

Làm sao để biết Google Bot có crawl được website hay không?

Bạn có thể sử dụng Google Search Console. Truy cập vào báo cáo crawl để xem tình trạng của các trang đã được Googlebot quét. Nếu có bất kỳ lỗi nào, bạn sẽ nhận được thông báo và có thể điều chỉnh để giúp quá trình crawl diễn ra hiệu quả hơn.

Tìm hiểu thêm:

- SEO là gì? Vì sao doanh nghiệp nên làm SEO ngay hôm nay?

- Website là gì? Các loại trang web phổ biến hiện nay

- Từ khoá là gì? Cách sử dụng từ khoá hiệu quả trong SEO

Việc hiểu rõ vai trò của crawl là gì và làm thế nào để cải thiện quá trình crawl data là bước đầu tiên để tối ưu hóa hiệu quả SEO của website. Nếu có bất kỳ thắc mắc nào, bạn hãy bình luận bên dưới bài blog để được Pima Digital phản hồi nhanh chóng và chính xác nhé!

PIMA DIGITAL – CÔNG TY SEO UY TÍN, CHUYÊN NGHIỆP

- Địa chỉ: Tầng 3, NCC Office, 139/37-39 Nguyễn Văn Lượng, Phường 10, Gò Vấp, TP.HCM

- Hotline: 0973.463.486

- Email: info@pimadigital.vn

- Website: https://pimadigital.vn/